Diez días antes del nombramiento de Donald Trump como presidente, a las 9.00 horas del 10 de enero, Barack Obama ofreció su discurso de despedida como Presidente en el McCormick Place de Chicago. Utilizó su discurso final para advertir al pueblo de los Estados Unidos de que la democracia estadounidense está amenazada por la desigualdad económica, la división racial y, la aparición de unos medios de comunicación fragmentados y tendentes a la auto-afirmación, en un tono poco sutil que evocó el de la campaña electoral. El problema, según Obama, es que nos hemos arropado cada vez más en nuestras cómodas burbujas de información, aislados unos de otros gracias a «hechos» alternativos.

Sólo unas horas antes, a las 5:20 pm EST, BuzzFeed publicaba un dossier de rumores infundados sobre la conducta financiera y sexual del presidente electo Trump en Rusia. El documento, compilado por el ex agente de inteligencia británico Christopher Steele, había circulado durante meses entre periodistas que no pudieron verificar su contenido. Ese mismo día, incluso más temprano, la CNN informaba que tanto el Presidente Obama como el Presidente Electo Trump habían sido informados sobre el expediente. BuzzFeed publicó todo el documento, razonando que la gente tenía el derecho de juzgar su contenido por sí mismos.

El editor en jefe de BuzzFeed News, Ben Smith, apareció más tarde en el programa Reliable Sources de la cadena CNN, para realizar un debate acalorado con el anfitrión Brian Stelter, centrado en la distinción entre la mención de CNN de la existencia del dossier y la publicación de BuzzFeed del mismo documento. En el centro de su disputa estaban las nociones competitivas de periodismo. Como resumió Stelter, mientras que las agencias de noticias tradicionales parten de la premisa de que el documento que se informa no debe ser compartido con el público, los nuevos medios parten del supuesto del ¿Por qué no?

A la mañana siguiente, Donald Trump pasó gran parte de su primera rueda de prensa como presidente electo denunciando el contenido del expediente Ruso y socavando el periodismo que se hizo eco del mismo en público. Llamó a CNN «noticias falsas», comparó la publicación del expediente con algo que podría haber ocurrido en la Alemania nazi, y dijo que BuzzFeed, «un montón de basura fallida», «sufriría las consecuencias» de su publicación.

Esa misma mañana, Facebook anunció el Facebook Journalism Project (El proyecto de Periodismo Facebook) y declaró que la empresa se comprometería en tres frentes: construyendo mejores herramientas para que los editores refuerzen sus modelos de negocio, ofreciendo cursos de capacitación para periodistas e iniciando un programa de alfabetización mediática para el resto. El anuncio fue una rápida respuesta tanto al creciente descontento de los editores con el pobre retorno económico ofrecido por Facebook Instant Articles, y una respuesta pública a la estrecha vinculación entre Facebook y las «noticias falsas» señalado por la cobertura mediática del tema. El anuncio también inició un convenio con verificadores de hechos por parte de terceros, por medio del cual los usuarios pueden señalar con mayor facilidad las noticias sospechosas.

Este período de 24 horas ilustra cómo los medios de comunicación y la política han cambiado en los años previos a las últimas elecciones, cuando una red de medios de comunicación claramente de derechas, compuesta de distribuidores relativamente nuevos, surge a partir de las elecciones de 2008. Una parte de sus objetivos fue desacreditar a los principales medios de comunicación y desarrollar una narrativa alternativa a la de los mismos con Facebook como un vector crucial para distribuir sus noticias. La campaña electoral de Trump se alineó con ese modelo mediante una gran inversión en Facebook para amplificar sus mensajes.

Los resultados de las elecciones reverberaron por todo Facebook y han obligado a esta empresa a revertir su actitud respecto al periodismo. Al animar a las agencias de noticias a hacer un uso total de Facebook como canal de distribución, Facebook ha puesto las herramientas de publicación al alcance de todos los demás también. Si bien la rápida difusión de la desinformación durante las elecciones en Facebook fue el problema más destacable sin duda alguna, también señala un mayor problema estructural causado por el modelo económico y el sistema de automatización que supone el mismo núcleo de Facebook.

La serie de iteraciones sobre cómo se monetiza la plataforma y sobre cómo se difunde y filtra la información ha clarificado los desafíos a los que enfrenta el negocio del periodismo actual y explica en última instancia la creación de un sistema que exacerba la difusión de información falsa durante la campaña electoral de 2016.

De amigos y familiares a noticias virales

Unos días después de que la primera historia sobre el fenómeno de «noticias falsas» escrito por Alex Kantrowitz de BuzzFeed se viralizase en Facebook, Mark Zuckerberg reiteró que Facebook es una plataforma, no un editor. «Somos una empresa de tecnología, no una empresa de medios», dijo a un grupo de estudiantes italianos mientras viajaba a Italia para ver al Papa a finales de agosto, «Construimos las herramientas, no producimos ningún contenido».

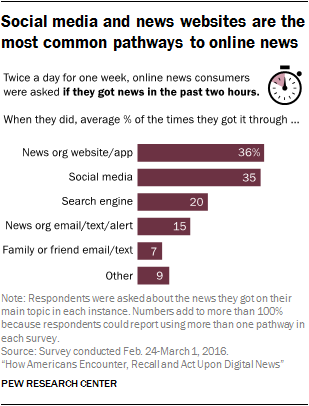

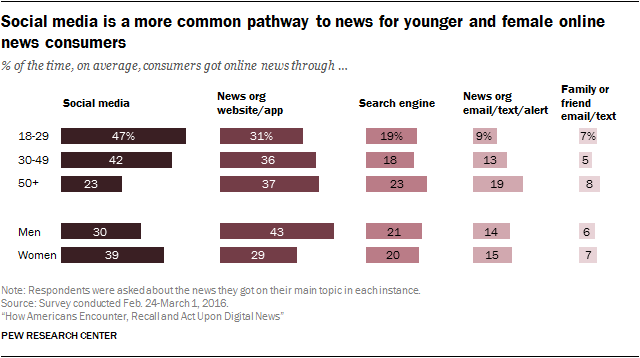

Sin embargo, Facebook es sin duda la mayor empresa editorial del mundo: con 1.900 millones de usuarios activos y 2 billones de entradas explorables, la plataforma llega a más personas que cualquier otra empresa de medios de la historia. Un estudio reciente de Pew (2016) encontró que el 67 por ciento de los adultos estadounidenses están activos en Facebook y que el 47 por ciento de los estadounidenses siguen las noticias en esta plataforma. Este es un número asombroso, y eclipsa completamente otras plataformas de medios sociales: Twitter es la segunda plataforma más popular, el 16 por ciento de los estadounidenses la utiliza pero sólo el 9 por ciento sigue noticias en la misma. El alcance de Twitter se extiende más allá de estas cifras ya que los tuits, y no solo los de Donald Trump, se incrustan y amplifican en todos los medios; pero es Facebook el amo de la audiencia. Tal y como John Herrman, el compañero de David Carr en el New York Times, indica, Facebook «no sólo se ha hecho casi omnipresente entre los usuarios de Internet estadounidenses, ha centralizado el consumo de noticias en línea de una manera sin precedentes».

Esta situación también es notable en comparación con los medios tradicionales: por ejemplo, en 1980 el 42 por ciento de los estadounidenses veía las noticias de la ABC, la NBC y la CBS y sólo 3,56 millones de estadounidenses estaban suscritos a la mayor editorial de periódicos de entonces, Gannett Co.

El papel de Facebook en el centro del ecosistema periodístico es un fenómeno nuevo, como se ha vio en la campaña de reelección de Obama, cuando Facebook desempeñó un papel muy diferente en el campo del periodismo.

En noviembre de 2012, una foto de Barack y Michelle Obama abrazados, con el texto «Cuatro años más», se convirtió en el tuit más compartido de la historia, como informó Kantrowitz en BuzzFeed.

Mientras que Twitter era entonces mucho más pequeño que Facebook – en 2012, tenía solamente 200 millones de usuarios, contra el 1,06 millardo de Facebook – ya emergía como una amenaza. No en su alcance general, sino en el tipo de intercambios de instante-a-instante necesarios para alimentar las visitas regulares de los usuarios. La función retweet de Twitter permitió que los contenidos se viralizasen mucho más fácilmente que en Facebook, donde en ese momento el contenido aún debía de compartirse manualmente. Mientras que Facebook tenía usuarios regulares, gran número de ellos solo utilizaban el servicio para registrar a familiares y amigos.

Ocho días después, Facebook lanzó su equivalente al retweet: el botón Compartir. Esta característica permitió a los usuarios circular fácilmente una entrada con sus seguidores, empujando el mismo hacia una audiencia cada vez mayor. En 2013, Facebook añadió hashtags y, en enero de 2014, una sección de «Tendencias», en la que se enumeran los temas más populares junto al News Feed.

Según la conclusión de Kantrowitz «La adición de una gran cantidad de características similares a Twitter dio a Facebook una nueva capacidad para difundir rápidamente el contenido del momento. Facebook todavía no era tan rápido como las actualizaciones en tiempo real de Twitter, pero no tenía por qué serlo. Era lo suficientemente rápido, y con sus 1.000 millones de usuarios activos mensuales, en comparación con los 250 millones más o menos de Twitter, compensó con masa lo que le faltaba en energía».

Simultáneamente, Facebook experimentaba con el algoritmo de News Feed. Dado que el algoritmo determina qué contenido ve cada usuario individual, puede ajustarse para reflejar los datos o el comportamiento del usuario. Por ejemplo, Nicole B. Ellison y Danah Boyd, dos académicos especializados en comunicación y medios, proponen que la plataforma puede determinar quién de sus ‘amigos’ son los más importantes para el usuario y prioriza los mensajes de este subconjunto de usuarios. La adición de la capacidad de ocultar mensajes de ciertos usuarios/páginas de Facebook en 2011 dio al algoritmo más información sobre el tipo de información que cada usuario desea ver. Según un estudio realizado por empleados de Facebook titulado «Exposición a noticias y opiniones ideológicamente diversas sobre Facebook» (2015), estas preferencias individuales personalmente seleccionadas tienen mayor peso para el algoritmo respecto al contenido que el muestra a cada usuario. Facebook también realizó un controvertido experimento sobre las respuestas emocionales de un usuario ante diferentes tipos de contenido, lo que en teoría les permite priorizar la información que más “feliz» a los usuarios. En su forma más simple, estos datos ayudan a adaptar el Feed de Noticias a las preferencias de cada usuario.

El resultado es que cuando un editor publica un artículo de periodismo en Facebook, a menos que pague por exposición, no sabe si aparecerá incluso en las feeds de sus seguidores. En el sistema de información de Facebook, el control sobre la distribución del periodismo se cede al algoritmo, y el algoritmo de NewsFeed decide lo que los usuarios ven primero cuando abren Facebook. Esta ecuación se repite constantemente para optimizar la experiencia y maximizar el valor comercial del News Feed. A los lectores se les muestra el material con el que más probablemente estarán de acuerdo, porque gustos y acciones son la moneda del mercado publicitario. Además, para alentar a los editores a compartir contenido, Facebook ha desarrollado nuevas herramientas para ayudar en la creación y distribución de periodismo, y ha desarrollado incentivos financieros para acompañarlo.

Desde luego, todo esto pretendía ser una mejora de las limitaciones de los medios tradicionales y de alguna manera lo es. La audiencia ya no tiene que confiar en un número limitado de fuentes para filtrar y agrupar todo su contenido multimedia. En una sesión de preguntas y respuestas en noviembre de 2014, Zuckerberg afirmó que el objetivo de Facebook era «construir el periódico personalizado perfecto para cada persona del mundo. Estamos tratando de personalizarlo y mostrar lo que va a ser más interesante para uno». Esto era necesario, argumentó, porque los usuarios estaban cada vez más expuestos a un gran número de noticias, de las cuales sólo podían consumir una pequeña fracción. «Hay más competencia por lo que (los usuarios) ven, por lo que sólo el contenido de la más alta calidad podrá alcanzarlos.» Cuando el algoritmo determina qué contenido es de alta calidad Facebook se convierte en la puerta de entrada a la audiencia.

La consecuencia inmediata, sin embargo, no fue un periódico personalizado, sino la aparición de una industria casera de empresas que buscan capitalizar el potencial viral del contenido en Facebook. Facebook ha sido capaz de traducir su espectacular número de usuarios activos en ingresos publicitarios, sobre todo en móviles. Tal como documenta Tim Wu en The Attention Merchants (2016), la nueva tecnología de publicidad programática permitió el micro-targeting de audiencias, impulsando el crecimiento de los ingresos de las grandes compañías de plataforma.

Cualquier editor de contenido, legítimo o no, podría jugar el algoritmo para aumentar las posibilidades de que el contenido se vuelva viral. Mediante la creación de contenido que se dirija directamente a un electorado en particular, con titulares seductores o incluso salaces, cualquier persona podría crear artículos que serían compartidos ampliamente, independientemente de a lo que se redirijan. Mientras que algunos, como Upworthy, intentaron aprovechar el algoritmo de Facebook para hacer que los mensajes positivos fueran virales, otros se beneficiaron de la capacidad de difundir información errónea, teorías de conspiración y bromas tal y como Craig Silverman ha documentado ampliamente para BuzzFeed.

La capacidad para crear contenido susceptible de convertirse en viral, sea por parte de agencias de noticias legítimas o por fabricantes de contenido más cuestionable, se ha convertido en un problema creciente para Facebook; el cibercebo es frustrante para los usuarios y el exceso de desinformación esta empezando a afectar la calidad de la información que los usuarios encuentran en Facebook. El informe de Craig Silverman para el Tow Center “Lies, Damn Lies and Viral Content” (2015), arguye que las agencias de noticias dominantes también son culpables de circular historias falsas o engañosas, y a menudo fallan en corregirlas porque están persiguiendo clics: «Más que actuar como fuente de información precisa, los medios de comunicación en línea suelen promover la desinformación en un intento de impulsar el tráfico y capturar la atención social. El resultado es una situación donde las mentiras se propagan mucho más allá que la verdad, y las agencias de noticias desempeñan un poderoso papel en todo esto.

La respuesta de Facebook a estas cuestiones fue el anuncio en enero de 2015 de que «una publicación con un enlace a un artículo que mucha gente ha reportado como engañoso o ha elegido borrar obtendrá una distribución reducida en News Feed». La compañía anticipó que esto se traduciría en disminución de audiencias para los engaños y estafas, pero en realidad se convertiría en el primero de una serie de intentos de sofocar el problema, generalmente fracasados. Si se desea escalar las soluciones al flujo masivo de contenido de Facebook, necesitan ser algorítmicas, en lugar de humanas, y es muy difícil enseñar a los algoritmos a resolver complejas cuestiones sobre la verdad y la falsedad.

Seguidamente, en abril de 2015, Facebook comenzó a priorizar los mensajes de amigos y familia de los usuarios sobre los de los editores que siguen normalmente, ya que los usuarios, con sus canales de noticias abarrotados de cibercebo, estaban preocupados por la «falta de actualizaciones importantes».

Casi un año después, los esfuerzos de Facebook para adaptar el News Feed con el fin de facilitar compartir y poder evolucionar hacia un flujo de información más regular tuvieron el efecto deseado. Como informó la página web de tecnología The Information, la gente estaba compartiendo más, pero, también estaban publicando menos.

5 de septiembre de 2006: Lanzamineto del News Feed de Facebook.

25 de agosto de 2014: Algoritmo de Facebook News Feed alterado para reducir la prioridad del cibercebo.

20 de enero de 2015: Algoritmo de Facebook News Feed alterado para «mostrar menos engaños».

21 de abril de 2015: Facebook afina el Feed de noticias para enfatizar la familia y los amigos porque la gente está preocupada por «falta de actualizaciones importantes.»

7 de mayo de 2015: Facebook publica una investigación interna sobre “filtros de burbuja” que concluye que «la mayoría tiene amigos que defienden una ideología política opuesta a la suya, y que el contenido de los News Feeds de la gente refleja esos puntos de vista diferentes».

15 de junio de 2015: El algoritmo del feed de noticias de Facebook se actualiza para priorizar el tiempo gastado en una historia por encima de la atención.

21 de abril de 2016: Facebook ajusta el algoritmo para centrarse en los artículos que es probable que la gente pase tiempo viendo.

9 de mayo de 2016: Gizmodo revela detalles de que los Trending Topics de Facebook están activamente “comisariados” por personas que «suprimieron» noticias conservadoras.

12 de mayo de 2016: Facebook publica un documento interno de 28 páginas en el que se delinean las directrices para el personal de curado de Trending Topics, en respuesta a la información de los medios de comunicación que sugiere un sesgo potencial.

23 de mayo de 2016: El consejo de Facebook responde a los republicanos del Congreso preocupados por el sesgo mediante una carta; la semana anterior, el equipo jurídico de Facebook se había reunido con el presidente del Comité de Comercio del Senado de los Estados Unidos, John Thune.

24 de mayo de 2016: Facebook dice que revisará la forma en que cura su sección de Trending topics, incluyendo dejar de usar páginas web externas para validar la importancia de una historia.

29 de junio de 2016: El algoritmo de Facebook cambia para énfatizar la familia y los amigos y en crear un feed que «informará» y «entretendrá».

4 de agosto de 2016: Facebook ajusta el News Feed para reducir la presencia de cibercebo.

11 de agosto de 2016: El feed de noticias de Facebook es modificado para poner énfasis en los artículos «personalmente informativos».

26 de agosto de 2016: Facebook Trending pasa a ser completamente impulsado por un algoritmo.

19 de noviembre de 2016: En respuesta a la presión post-electoral, Mark Zuckerberg aborda el papel de Facebook en las noticias falsas.

5 de diciembre de 2016: En un esfuerzo por combatir la desinformación, Facebook pide a los usuarios que denuncien el «lenguaje engañoso».

11 de enero de 2017: Facebook anuncia el Proyecto de Periodismo de Facebook, para trabajar con editores en implementación de productos, formatos de narración, promoción de noticias locales, modelos de suscripción, capacitación de periodistas y colaboración con el Proyecto de Alfabetización de Noticias y organizaciones de verificación de hechos. El mismo día, TechCrunch informa que Facebook acepta censurar contenido en Tailandia a petición del gobierno.

31 de enero de 2017: Facebook actualiza el algoritmo para dar prioridad al contenido «auténtico» y publicará mensajes en tiempo real/noticias de última hora.

6 de febrero de 2017: Las noticias revelan que un refugiado sirio identificado como terrorista persigue acciones legales contra Facebook sobre la base de las «noticias falsas».

8 de febrero de 2017: Surgen noticias sobre las quejas de que los editores franceses sobre el esfuerzo necesario para realizar el convenio sobre noticias falsas de Facebook.

16 de febrero de 2017: Mark Zuckerberg escribe un manifiesto de casi 6.000 palabras, «Building Global Community», sobre el futuro de Facebook y la sociedad civil global.

3 de marzo de 2017: Facebook lanza su etiqueta de «noticias disputadas».

A día de hoy, Facebook sigue luchando para encontrar la forma de incentivar la difusión de una buena información y disuadir la perniciosa. Un engaño o una mentira viral proporcionan a un editor cuestionable ganancias a corto plazo, pero perjudica la credibilidad de Facebook y puede tener una seria repercusión en la comprensión pública. Los esfuerzos iniciales para definir y abordar este problema se centraron en la información engañosa, pero la realidad es que la raíz del problema es que tanto los buenos como los malos contenidos están incentivados por el mismo conjunto de herramientas y cambios algorítmicos. Es muy difícil detener la propagación de la desinformación sin limitar también la propagación del periodismo a menos que empiecen a tomar decisiones editoriales sobre cuales son las organizaciones en que se puede confiar.